谷歌Gemini_1.5发布,多模态硬刚GPT-5,100万极限上下文纪录

谷歌刚刚发布其大模型矩阵的最新力作——Gemini 1.5Pro,并将上下文窗口长度扩展到100万个tokens。

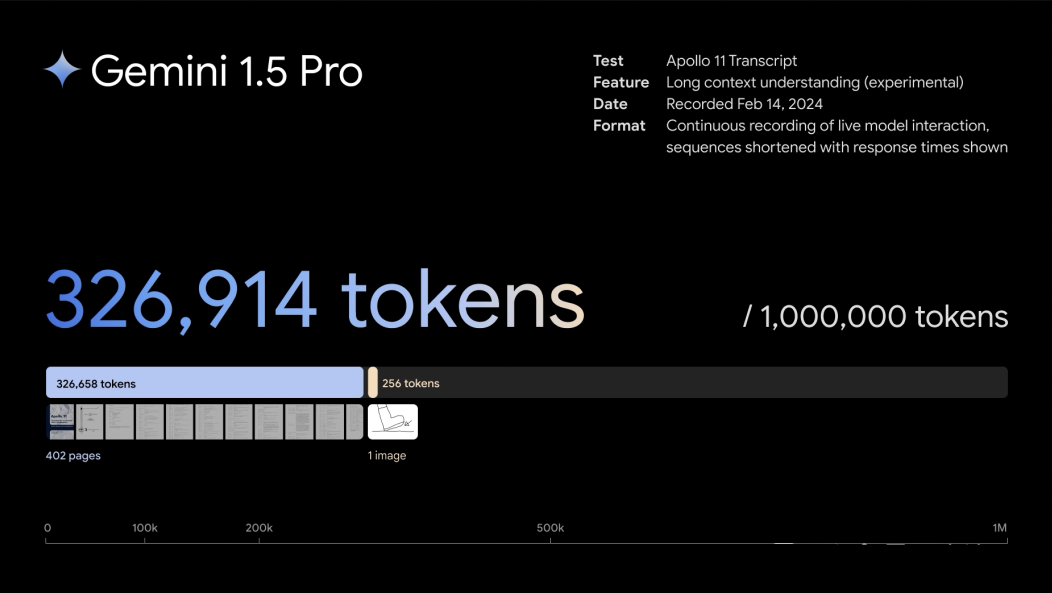

Gemini 1.5 Pro达到了与1.0 Ultra相当的质量,同时使用了更少的计算。该模型在长语境理解方面取得突破,能够显著增加模型可处理的信息量——持续运行多达100万个tokens,实现迄今任何大型基础模型中最长的上下文窗口。

这意味着Gemini 1.5 Pro可一次处理大量的信息——包括1小时的视频、11小时的音频、超过3万行代码或超过70万字的代码库。

测试了一下,只要绑卡就能免费试用 2 个月的 Google One(记得 2 个月后取消订阅),就可以用 Gemini Ultra 了(美国、加拿大 IP),好像并没有对话数量的限制?中文虽然可以回答,但能力不全,不能画图,也不能调用 Google 插件。 英文下基本是全能力的,图像理解、生成,调用 Google Workspace、YouTube 等能力。 App:iOS 端没有单独的 App,和 Google 整合在一起,但还没有更新;安卓可以下载单独的 Gemini App,但我目前不能用,提示地区不支持(但网页版是可用的)。

1 Gemini 1.5 Pro带来了什么

更大的處理能力

1,000,000 token超超超长上下文

自家最强的Gemini 1.0 Ultra才发布没几天,谷歌又放大招了。

就在刚刚,谷歌DeepMind首席科学家Jeff Dean,以及联创兼CEO的Demis Hassabis激动地宣布了最新一代多模态大模型——Gemini 1.5系列的诞生。

其中,最高可支持10,000K token超长上下文的Gemini 1.5 Pro,也是谷歌最强的MoE大模型。

不难想象,在百万级token上下文的加持下,我们可以更加轻易地与数十万字的超长文档、拥有数百个文件的数十万行代码库、一部完整的电影等等进行交互。

同时,为了介绍这款划时代的模型,谷歌还发布了长达58页的技术报告。

论文地址: https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

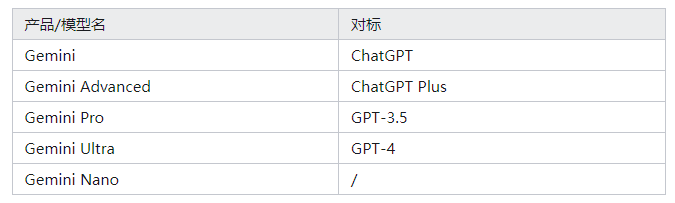

产品

毫不夸张地说,大语言模型领域从此将进入一个全新的时代!

Gemini 1.5 Pro 1,000,000 token超超超长上下文,全面碾压GPT-4 Turbo

在上下文窗口方面,此前的SOTA模型已经「卷」到了200K token(20万)。

如今,谷歌成功将这个数字大幅提升——能够稳定处理高达100万token(极限为1000万token),创下了最长上下文窗口的纪录。

1000万token极限海底捞针几乎全绿

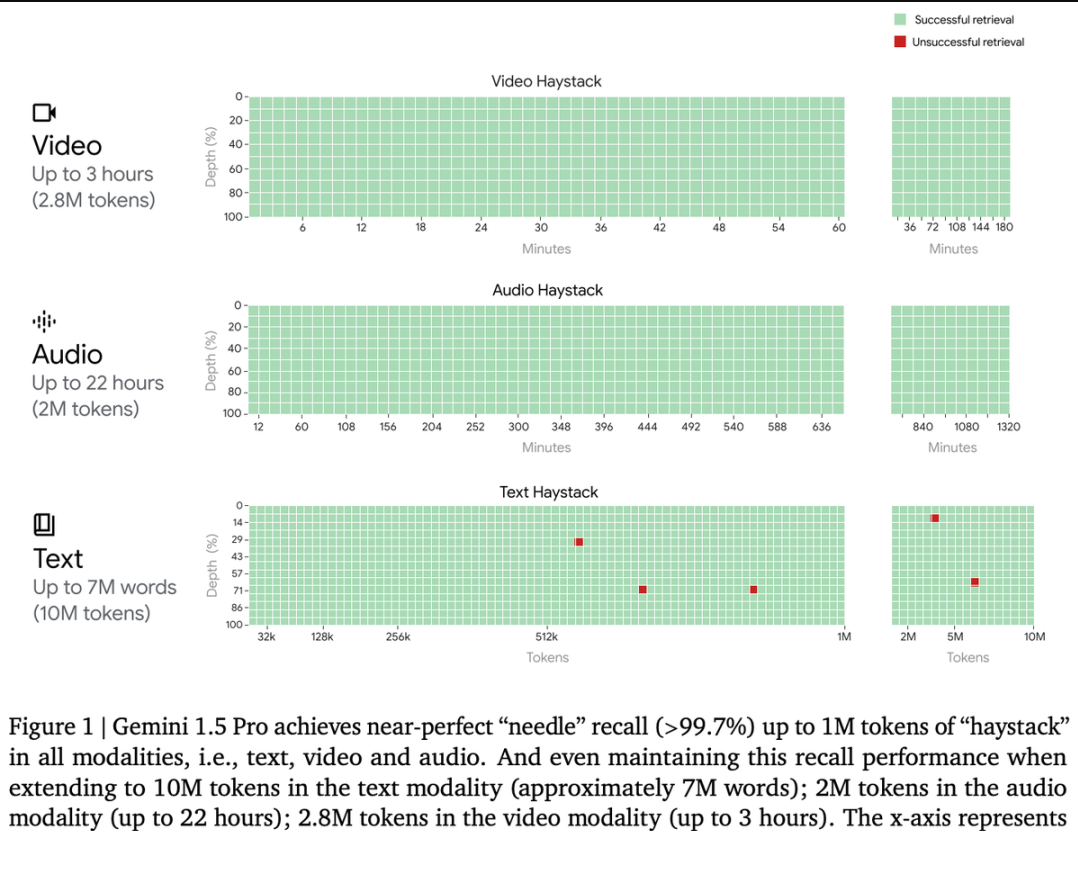

首先,我们看看Gemini 1.5 Pro在多模态海底捞针测试中的成绩。

对于文本处理,Gemini 1.5 Pro在处理高达530,000 token的文本时,能够实现100%的检索完整性,在处理1,000,000 token的文本时达到99.7%的检索完整性。

甚至在处理高达10,000,000 token的文本时,检索准确性仍然高达99.2%。

在音频处理方面,Gemini 1.5 Pro能够在大约11小时的音频资料中,100%成功检索到各种隐藏的音频片段。

在视频处理方面,Gemini 1.5 Pro能够在大约3小时的视频内容中,100%成功检索到各种隐藏的视觉元素。

此外,谷歌研究人员还开发了一个更通用的版本的「大海捞针」测试。

在这个测试中,模型需要在一定的文本范围内检索到100个不同的特定信息片段。

在这个测试中,Gemini 1.5 Pro在较短的文本长度上的性能超过了GPT-4-Turbo,并且在整个100万token的范围内保持了相对稳定的表现。

与之对比鲜明的是,GPT-4 Turbo的性能则飞速下降,且无法处理超过128,000 token的文本,表现惨烈。

大模型视野,被「史诗级」拓宽

LLM发展到这个阶段,模型的上下文窗口已经成为了关键的掣肘。

模型的上下文窗口由许多token组成,它们是处理单词、图像、视频、音频、代码这些信息的基础构建。

模型的上下文窗口越大,它处理给定提示时能够接纳的信息就越多——这就使得它的输出更加连贯、相关和实用。

而这次,谷歌通过一系列机器学习的创新,大幅提升了1.5 Pro的上下文窗口容量,从Gemini 1.0的原始32,000 token,直接提升到了惊人的1,000,000 token。

这就意味着,1.5 Pro能够一次性处理海量信息——比如1小时的视频、11小时的音频、超过30,000行的代码库,或是超过700,000个单词。

甚至,谷歌曾经一度成功测试了高达10,000,000的token。

深入理解海量信息

脱胎换骨的Gemini 1.5 Pro,已经可以轻松地分析给定提示中的海量内容!

它能够洞察文档中的对话、事件和细节,展现出对复杂信息的深刻理解。

我们甩给它一份阿波罗11号任务到月球的402页飞行记录,它对于多复杂的信息,都能表现出深刻的理解。

让它从文件中列举出3个喜剧性的时刻,接下来,就是见证奇迹的时刻——

才过了30秒出头,答案就已经生成了!

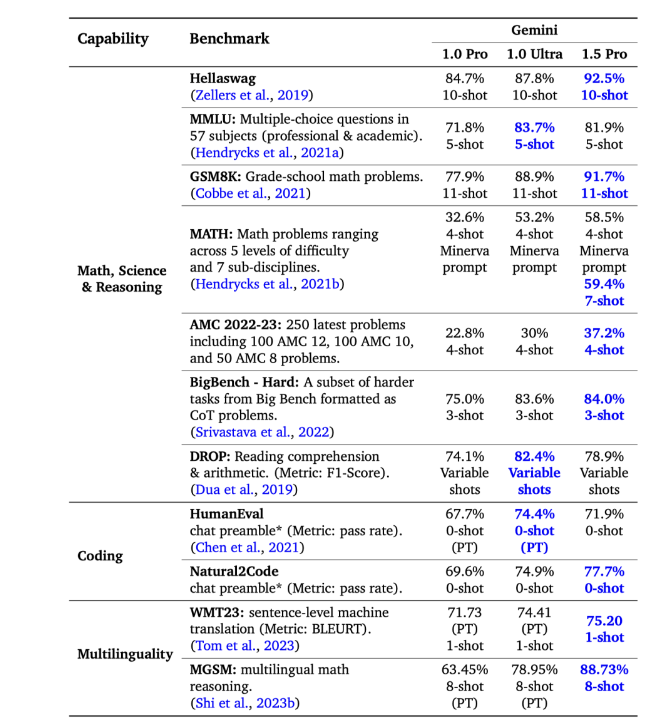

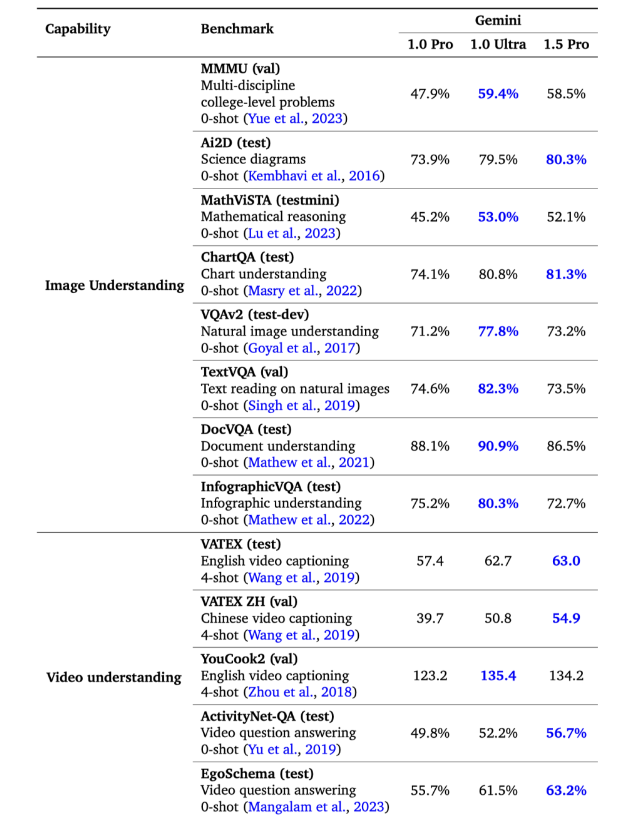

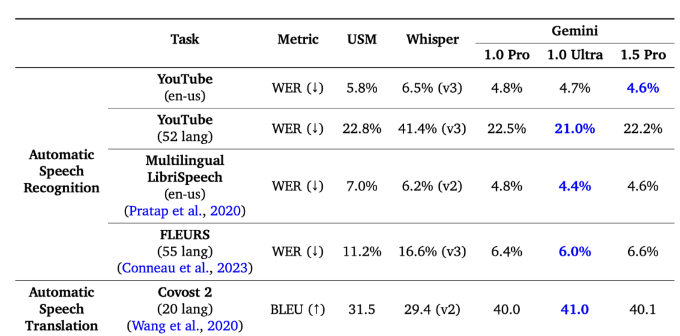

与1.0 Pro模型相比,Gemini 1.5 Pro在31项测试中的27项上,表现更佳。

Gemini 1.5 Pro细节表现:

2 Gemini Pro 1.5细节表现如何?

分析和掌握复杂代码库

这款模型能够迅速吸收大型代码库,并解答复杂的问题,这一点非常引人注目。

例如,three.js是一个包含约10万行代码、示例和文档等的3D Javascript库。

借助这个代码库作为背景,系统能够帮助用户深入理解代码,并能够根据人们提出的高层次要求来修改复杂的示例。

比如:「展示一些代码,用于添加一个滑块控制动画速度。采用和其他演示相同的GUI风格。」

或者精确地指出需要修改的代码部分,以改变另一个示例中生成的地形的高度。

浏览庞大而陌生的代码库

并且,模型能够帮我们理解代码,或定位某个特定功能的实现位置。

在这个例子中,模型能够处理整个包含116个文件的JAX代码库(746k token),并协助用户找到实现自动微分反向传播的确切代码位置。

显然,在深入了解一个陌生的代码库或日常工作中使用的代码库时,长上下文处理能力的价值不言而喻。

许多Gemini团队成员已经发现,Gemini 1.5 Pro的长上下文处理功能,对于Gemini 代码库大有裨益。

高效架构的秘密:MoE

Gemini 1.5的设计,基于的是谷歌在Transformer和混合专家(MoE)架构方面的前沿研究。

不同于传统的作为一个庞大的神经网络运行的Transformer,MoE模型由众多小型的「专家」神经网络组成。

这些模型可以根据不同的输入类型,学会仅激活最相关的专家网络路径。

这样的专门化,就使得模型效率大幅提升。

而谷歌通过Sparsely-Gated MoE、GShard-Transformer、Switch-Transformer、M4研究,早已成为深度学习领域中MoE技术的领航者。

Gemini 1.5的架构创新带来的,不仅仅是更迅速地掌握复杂任务、保持高质量输出,在训练和部署上也变得更加高效。

因此,团队才能以惊人的速度,不断迭代和推出更先进的Gemini版本。

性能比肩Ultra,大幅超越1.0 Pro

在涵盖文本、代码、图像、音频和视频的综合性测试中,1.5 Pro在87%的基准测试上超越了1.0 Pro。

与1.0 Ultra在相同基准测试的比较中,1.5 Pro的表现也相差无几。

Gemini 1.5 Pro在扩大上下文窗口后,依然保持了高水平的性能。在「大海捞针 (NIAH)」测试中,它能够在长达100万token的文本块中,在99%的情况下,准确找出隐藏有特定信息的文本片段。

此外,Gemini 1.5 Pro展现了卓越的「上下文学习」能力,能够仅凭长提示中提供的信息掌握新技能,无需进一步细化调整。

这一能力在「从一本书学习机器翻译 (MTOB)」基准测试中得到了验证,该测试检验了模型学习从未接触过的信息的能力。

对于一本关于全球不足200人使用的Kalamang语的语法手册,模型能够学会将英语翻译成Kalamang,学习效果与人类学习相似。

谷歌的研究者成功地增强了模型处理长文本的能力,而且这种增强并没有影响到模型的其他功能。

虽然这项改进只用了Gemini 1.0 Ultra模型训练时间的一小部分,但1.5 Pro模型在31项性能测试中的17项上超过了1.0 Ultra模型。

长篇复杂文档的推理

同时,模型在分析长篇、复杂的文本文档方面也非常出色,例如雨果的五卷本小说《悲惨世界》(共1382页,含732,000个token)。

下面这个简单的实验,就展示了模型的多模态能力:粗略地画出一个场景,并询问「请看这幅图画中的事件发生在书的哪一页?」

模型就能给出准确的答案——1099页!

Kalamang语翻译

报告中一个特别引人注目的例子是关于Kalamang语的翻译。

卡拉曼语是新几内亚西部、印度尼西亚巴布亚东部不足200人使用的语言,几乎未在互联网上留下足迹。

Gemini Pro 1.5通过上下文学习掌握了Kalamang语的知识,其翻译质量可与使用相同材料学习的人相媲美。

在英语到卡拉曼语的翻译中,Gemini Pro 1.5的ChrF达到了58.3,大幅超过了以往最好的模型得分45.8 ChrF,并略高于MTOB论文报告的57.0 ChrF人类基准。

这一成就无疑带来了令人激动的可能性,提升稀有语言的翻译质量。

Gemini 1.5的诞生,意味着性能的阶段飞跃,标志着谷歌在研究和工程创新上,又迈出了登月般的一步。

接下来能跟Gemini 1.5硬刚的,大概就是GPT-5了。

我非常非常期待谷歌给 OpenAI 上上强度,让 Gemini 早点把 GPT-5 逼出来,至于能不能…走着看吧。

3 Gemini 1.5 Pro试用的情况的总结

- 目前看来,代码生成能力很强大(我实验了 Python ,至少在 Python 上),感觉超越了GPT-4。虽然号称超越 GPT-4的大模型很多,但实际使用起来超越的,这个还是第一次。

- 更擅长翻译(尝试将中文和日文习语翻译成英文)

- 与 gpt-4 bing Chat(Bing Copilot) 相比,更擅长将搜索结果合并到其答案中,毕竟 Google 的搜索引擎,远好于 Bing。

- 图像理解能力,这个感觉也超越了 GPT-4v

- 对于写作和创造力来说是最好的,初步感觉质量上优于GPT4,在虚构故事方面,它更有创意,更少依赖陈词滥调,对叙事有更强的把握。

- 遵循指令能力也做的很不错,甚至要好于 GPT-4,比如向 Gemini 提出了一些我的想法,它立即变得至关重要,并在接下来的响应中提供了实际有价值的反馈。

- 与 Google 应用程序有良好的交互,这点只能和微软的 Office Copilot像比较了

- Gemini Advanced是付费订阅,是 Google One AI Premium 计划(这是更广泛的Google One产品的一部分)。每月费用为 19.99 美元/18.99 英镑,包括 2TB 云存储。算成人民币的话,显然19.99美元 合算,少了30元左右。

- Google = OpenAI + 微软,后者看双方后续合作是否还亲密无间了。

- 从价格来说,Google 更便宜,毕竟Google Advanced的20美元,等于 GPT-4 plus的20美元+微软 Copilot的30美元。当然,值不值,您说了算!